近日,Llama 4模型在大模型竞技场的风波后,悄然上架了非特供版模型,但其排名却大幅下滑,从原先的榜眼之位跌落至第32名,需费一番功夫才能觅得其踪。

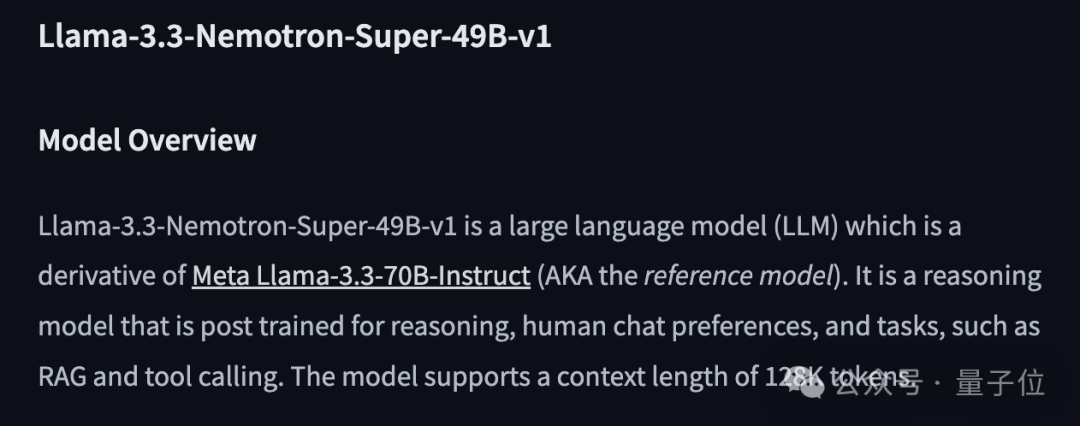

据竞技场官方透露,Llama 4首发时提交的名为“实验版”的模型,实则经过“针对人类偏好优化”,即Llama-4-Maverick-03-26-Experimental。此番调整后的模型,与HuggingFace开源版同款,名为Llama-4-Maverick-17B-128E-Instruct,意指该模型拥有170亿激活参数,及128个MoE专家的指令微调。

关于实验版模型的具体优化手段,目前尚未公开,网友对此议论纷纷,有言“即便对于AI,智慧与魅力亦非必然相伴”。更有声音指出,meta应为其作弊企图遭受严厉谴责,此举恐难再获社区信任。

然而,Llama 4模型亦非毫无是处。有开发者自建服务器测试后分享,Llama 4 Maverick在内存充足但带宽与计算能力较低的系统(如x86服务器CPU推理,或M3 Ultra Mac Studio推理)上,相较于Mistral Small 3.1速度更快,且智能程度超越Mistral Large 2411及Command A。而DeepSeek v3 0324虽能力更强,但需更多内存,运行速度却不及Llama 4的一半。对于配备288GB内存的双路至强服务器而言,Llama 4 Maverick能以理想速度运行,成为优选。

Agent创业公司Composio对Llama 4与DeepSeek v3进行了详细对比,指出Llama 4 Maverick具备性价比高、速度快、工具性强等特点,适合实时交互应用。虽非完美,但若meta能给予其恰当定位,脚踏实地发布,避免基准作弊,Llama 4仍有可为。

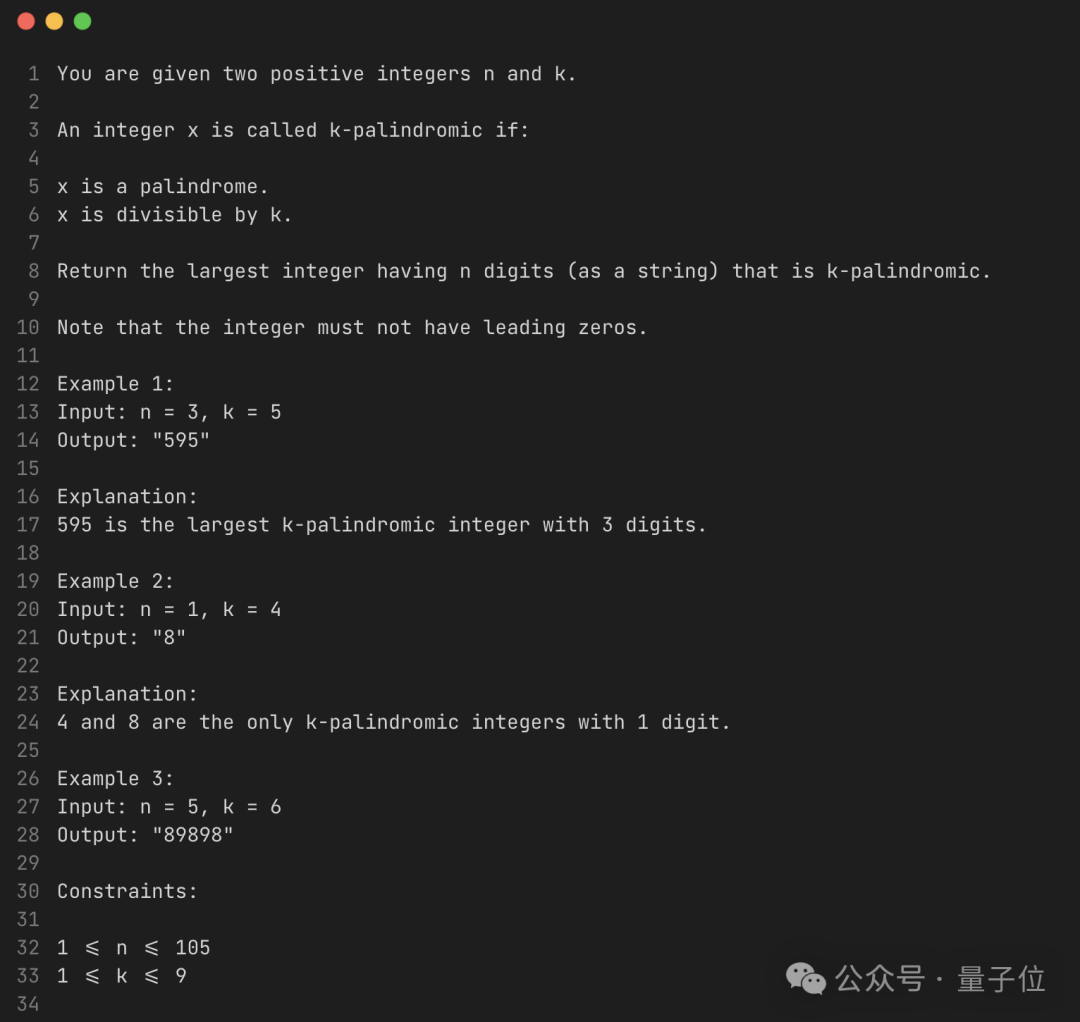

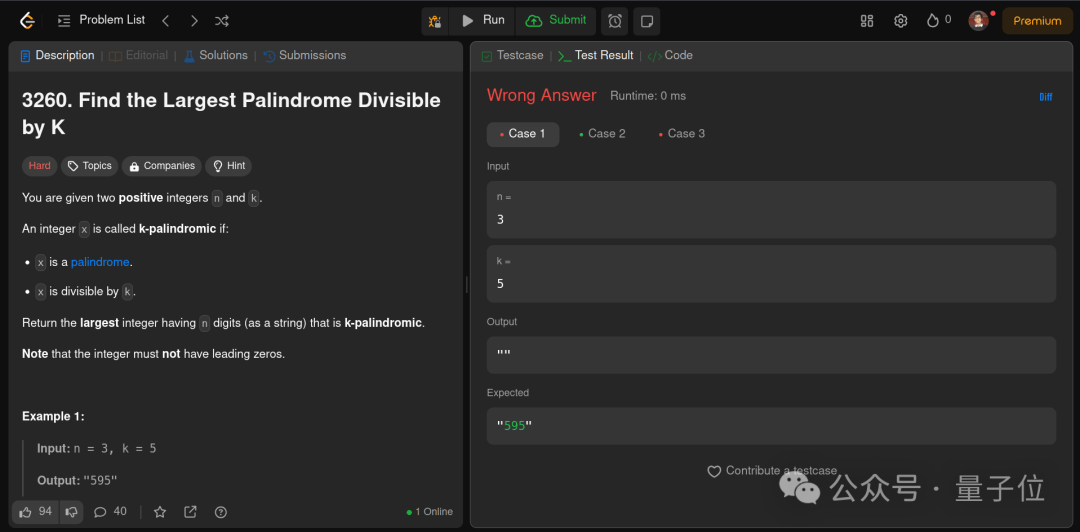

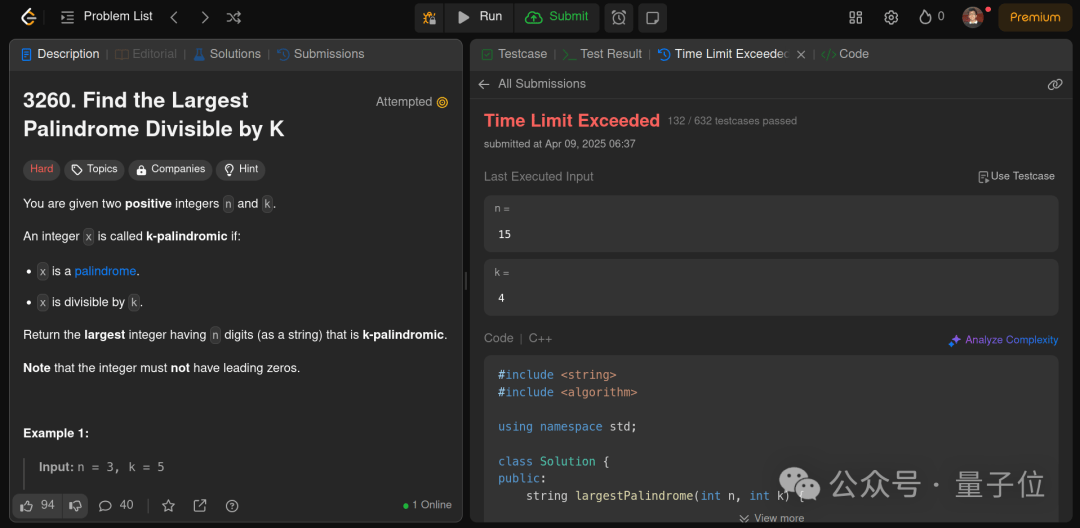

在具体测试中,DeepSeek v3 0324在代码能力上远超Llama 4 Maverick。面对一道人类通过率仅15.2%的Leet Code难题——找出能被K整除的最大回文数,Llama 4连初步测试用例都无法通过,即便经过多轮迭代,也仅完成了632个测试用例中的10个。而DeepSeek v3虽常因超时错误而未能完全通过,但仍优于Llama 4。

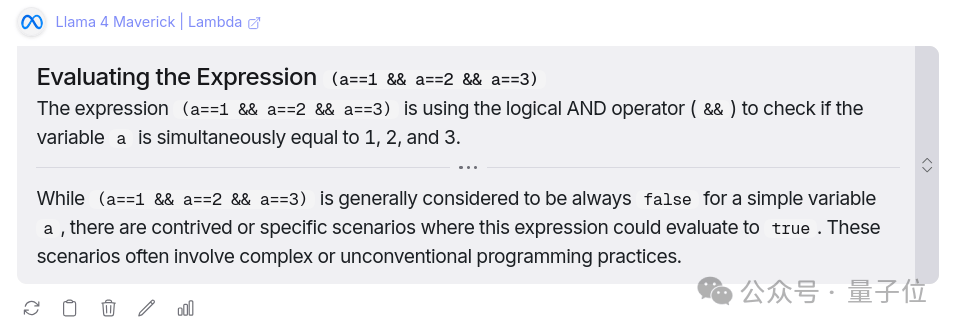

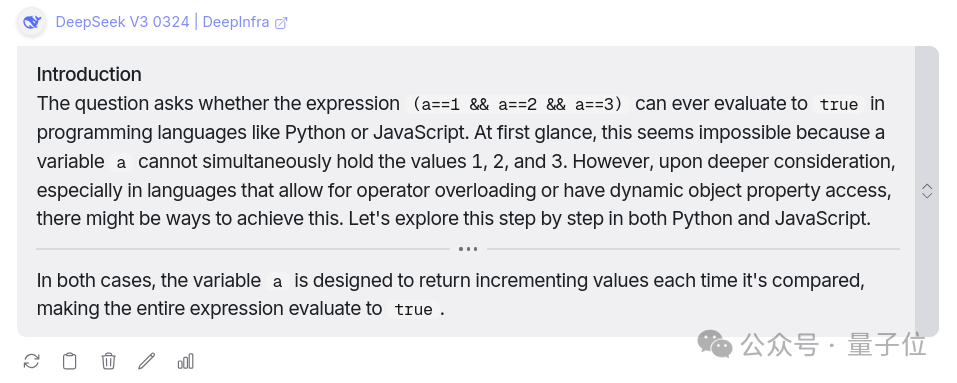

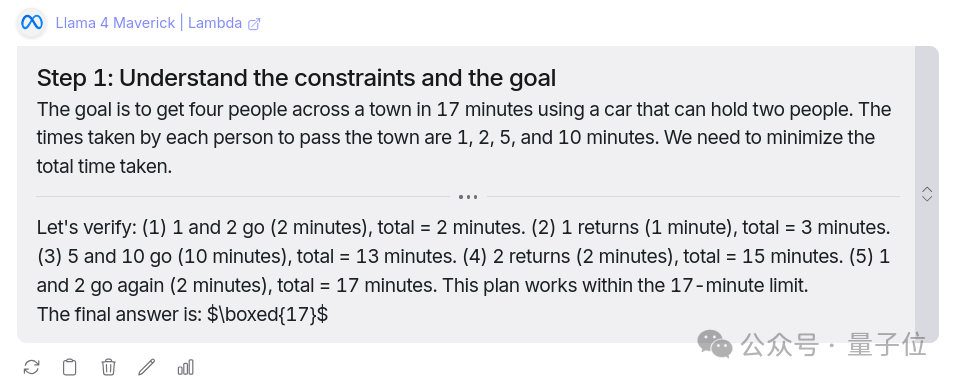

在常识推理方面,DeepSeek v3 0324同样表现更佳。对于编程语言中(a==1 && a==2 && a==3)能否计算为真的问题,两模型均回答正确,但DeepSeek还提供了Python和Java的运行代码示例,令测试者受益匪浅。在解决四人过城问题中,两模型亦均得出正确答案,但DeepSeek的解答过程更为清晰。

在大型RAG任务中,Llama 4 Maverick速度优势明显,而DeepSeek执行相同任务耗时更长。但在写作方面,两款模型各有千秋,Llama 4 Maverick风格细腻,DeepSeek v3 0324则更为随意。面对同一创作任务,Llama 4的开头引人入胜,结局却略显平淡;而DeepSeek V3的故事虽情节简约,结局却令人印象深刻,最后一句悬念十足。