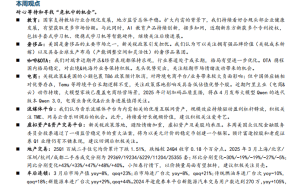

在人工智能领域,大语言模型(LLMs)的进化历程堪称奇迹。从最初的自动完成功能到如今展现出的强大推理能力,其变化令人瞩目。推理,这一人类智慧的象征,正逐步被大语言模型所掌握。

早期的LLMs,尽管能生成流畅的文本,但缺乏真正的智能——尤其是推理能力。真正的智能,意味着能够解决复杂问题,如数学难题、代码调试,以及逻辑推导,并能自我检查和纠正错误。然而,传统LLMs的训练目标往往局限于预测下一个词语,而非思考。那么,它们是如何实现这一华丽转身的呢?

这一切,得益于一系列创新技术的引入。从提示工程到代理工具的使用,这些技术共同推动LLMs向更有条理的思考者转变。其中,五种策略尤为关键。

首先,是“思维链提示”。这一方法鼓励LLMs在给出最终答案前,先产生中间推理步骤。例如,面对“17乘以24等于多少?”的问题,LLMs会被引导分解为更小的步骤,如“17×24=(20×17)+(4×17)”。这种方法不仅提升了多步推理能力,还让LLMs学会了“逐步思考”。

其次,是“推理时间计算扩展”。面对难题,人类会花更多时间思考,LLMs也应如此。通过分配更多的计算资源,LLMs能够生成多个推理路径,并选择最佳路径。OpenAI的o3-mini模型就提供了低、中、高三种推理程度选项,显著提升了在数学和编码任务上的表现。

再者,“强化学习和多阶段训练”也是提升推理能力的关键。通过强化学习,LLMs不仅模仿数据,还能因生成有逻辑的答案而受到奖励。DeepSeek-R1模型就是采用这种方法,开发出了强大的推理能力。同时,多阶段训练方法进一步提高了答案的可读性和准确性。

“自我纠正和回溯”策略则让LLMs在出错时能够意识到并改正错误。腾讯AI实验室的研究人员发现,对推理切换进行惩罚,并鼓励深入探索每个想法,可以有效提高准确率。同时,自回溯策略让LLMs在陷入僵局时重新回放推理过程,探寻更好的替代方案。

最后,“工具的使用以及外部知识的整合”让LLMs能够超越自身限制。通过调用外部工具,如计算器、代码解释器和API,LLMs能够处理更复杂的查询。阿里巴巴的QwQ-32B模型就集成了代理功能,使其能够在推理过程中调用函数或访问API。这种策略显著提高了准确性和可靠性。

LLMs的推理能力并非一蹴而就,而是通过一系列分层技术的叠加而获得的。这些技术包括训练、提示、推理以及与外部世界的互动。顶级LLMs,如OpenAI的o1和o3、DeepSeek的R1、谷歌的Gemini 2.0以及阿里巴巴的QwQ,正是结合了这些策略中的多种,才实现了真正的智能突破。