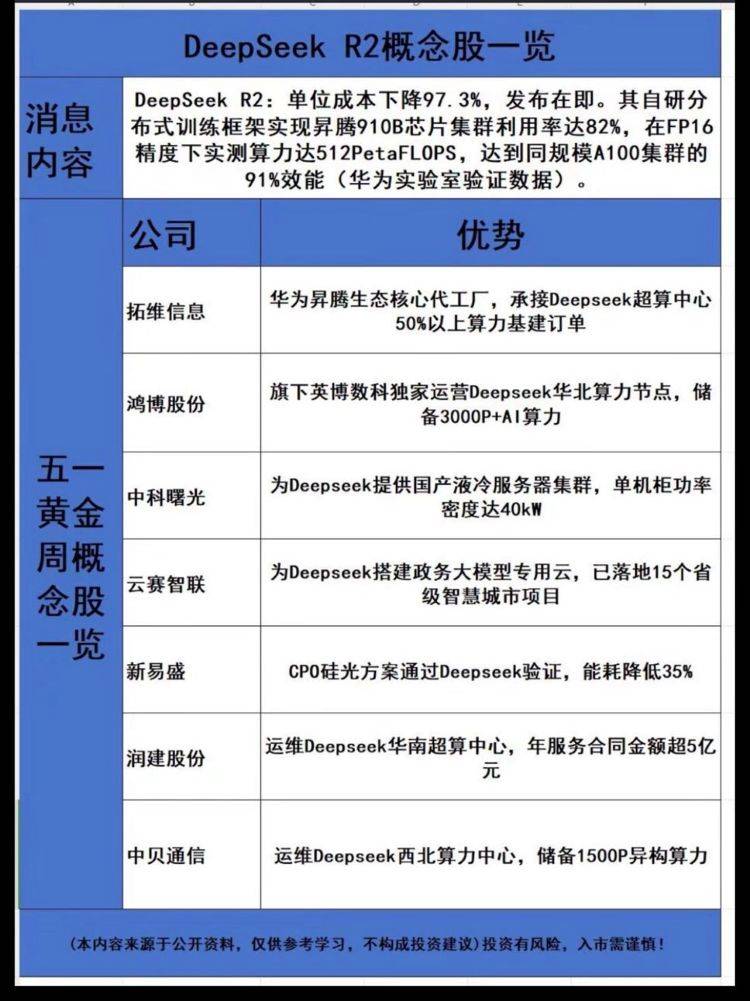

近日,AI领域迎来了一则重大爆料。知名玩家@deedydas在社交媒体上透露了深度求索公司即将推出的下一代AI大模型——DeepSeek-R2的详细参数信息,引发了广泛关注。

据悉,DeepSeek-R2将采用一种创新的混合专家模型(MoE)架构,并融入了更智能的门控网络层(Gating Network),旨在提升高负载推理任务的效率。这一改进使得DeepSeek-R2的模型总参数量达到了惊人的1.2万亿,相比其前代DeepSeek-R1(6710亿参数)实现了翻倍的增长。从规模上看,DeepSeek-R2已经与ChatGPT的GPT-4 Turbo以及谷歌的Gemini 2.0 Pro并驾齐驱。

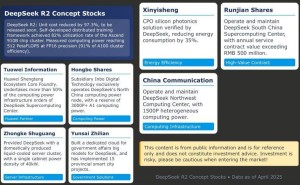

在硬件平台的选择上,DeepSeek-R2也取得了显著突破。该模型基于华为昇腾910B(Ascend 910B)芯片集群平台进行了训练,在FP16精度下实现了512 PetaFLOPS的计算性能,芯片资源利用率高达82%。据华为实验室数据显示,这一算力表现已接近英伟达上一代A100训练集群的91%,展现了华为在AI芯片领域的强大实力。

DeepSeek-R2在成本效益方面也表现出色。得益于华为昇腾910B训练集群的加持,DeepSeek-R2的单位推理成本仅为0.07美元/百万token,相较于GPT-4的0.27美元/百万token下降了97.4%。这一成本优势无疑将为DeepSeek-R2在市场上的竞争力增添不少筹码。

在当前美国对英伟达H20芯片实施断供的背景下,DeepSeek-R2选择采用华为昇腾910B训练集群无疑是一个明智之举。这不仅有助于降低对海外高端AI芯片的依赖,还进一步推动了我国在人工智能领域硬件自主化水平的提升。随着华为全新的昇腾910C芯片逐步进入大规模量产阶段,CloudMatrix 384超节点采用384颗昇腾910C芯片的方案,有望成为英伟达NVL72集群的有力替代,为我国AI产业的发展注入新的活力。