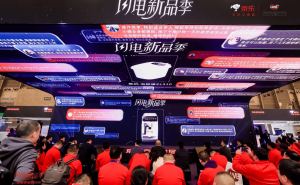

在近期举行的Nvidia GPU Technology Conference(GTC)2025大会上,Nvidia创始人黄仁勋发表了一项引人注目的观点:他认为,过去一年全球大多数人对Scaling Law(规模定律)的理解存在偏差。

Scaling Law,这一由AI创业公司OpenAI前联合创始人伊利亚·苏茨克维尔在2020年提出的理论,指出大模型的性能由算力、模型和数据规模共同决定。自其问世以来,已成为过去三年大模型训练的基石理论。各大科技公司如亚马逊、微软、谷歌、阿里、字节跳动和腾讯等,均基于这一理论,通过增加算力芯片的数量来提升模型性能。

然而,黄仁勋在GTC 2025上表示,Scaling Law正在变得更加坚韧,算力消耗实际上在加速。他透露,目前AI推理算力的需求量可能是2024年的100倍。这一说法引发了业界对Scaling Law的新一轮讨论。

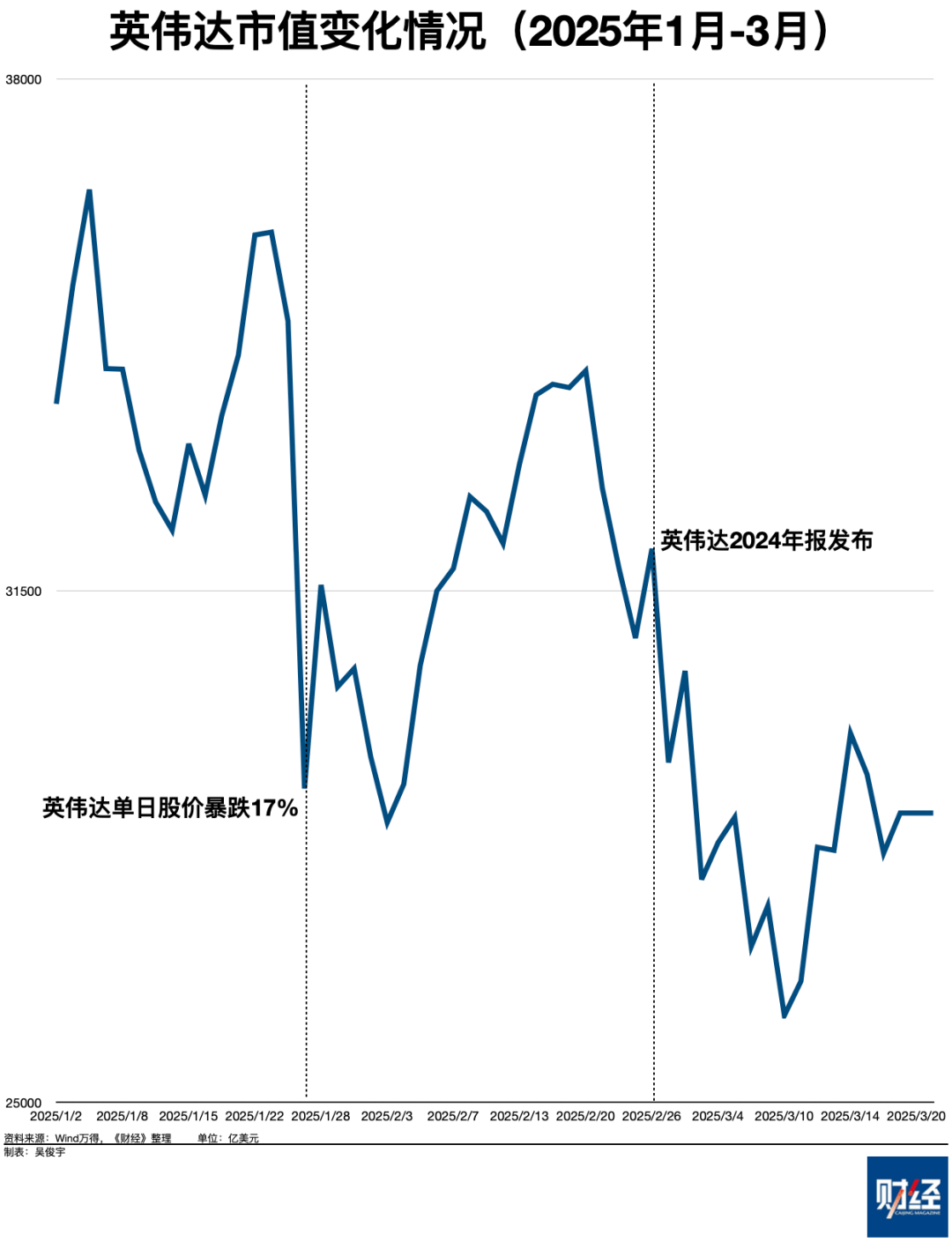

黄仁勋进一步指出,过去一年,由于Scaling Law的放缓,市场开始质疑堆算力是否仍然经济,进而影响到对Nvidia芯片的需求。这一质疑在今年1月达到高潮,当时中国大模型创业公司DeepSeek发布了一篇论文,声称用较少的Nvidia H800芯片和较低的训练成本,就训练出了与OpenAI的GPT-4o性能相近的DeepSeek-V3模型。这一成果让投资者担忧Nvidia芯片销量会受到影响,导致Nvidia股价一度单日下跌17%,市值蒸发近6000亿美元。

尽管如此,Nvidia在2月26日公布的2025财年财报显示,公司营收达到1304.9亿美元,同比增长114.2%;净利润728.8亿美元,同比增长148.5%。尽管业绩亮眼,但财报公布后,Nvidia股价仍持续下跌。这显示出投资者对Nvidia的信心并不坚定。

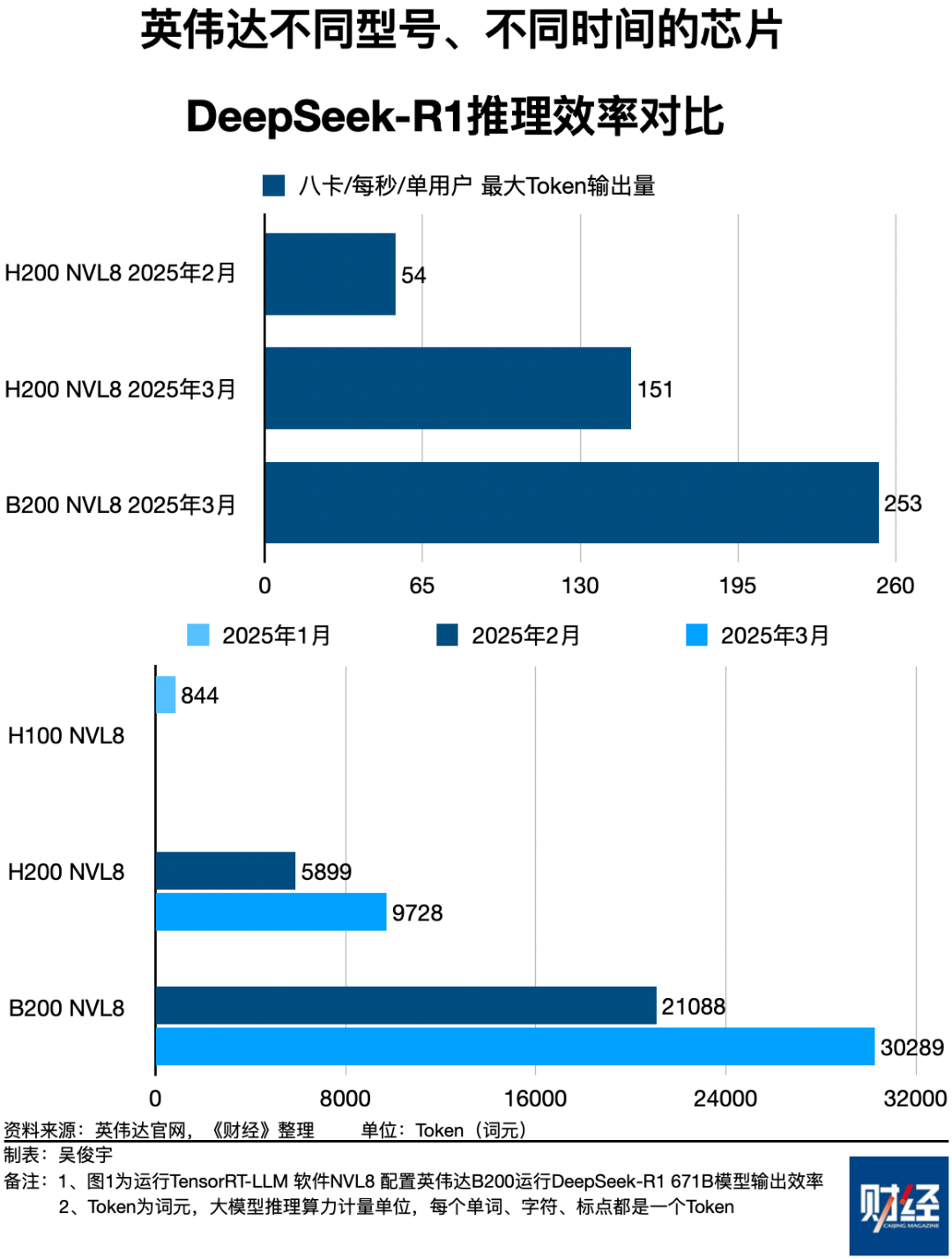

为了重拾投资者信心,黄仁勋在GTC 2025上重新解释了Scaling Law,将其称为“终极摩尔定律”。他强调,未来的重点将是提升推理效率,即在单位时间和能源下产生更多的Token(词元,大模型推理算力的计量单位)。他提出了两个关键指标:单个用户每秒生成的Token数量和单位电力下生成的Token数量。

黄仁勋还披露了Nvidia未来的芯片演进路线图,表示将每两年进行一次架构演进,每年推出新产品线,每次都会带来成倍的效率提升。他举例说,新一代Blackwell(GB200)芯片在相同功率下的效率是上一代Hopper(H100)芯片的25倍。如果一个100兆瓦功率的数据中心运行DeepSeek-R1模型,使用H100可以生成3亿个Token,而使用GB200则可以生成120亿个Token,Token收入将增长40倍。

黄仁勋还表示,Nvidia将帮助企业扩大数据中心规模,建成10万卡、100万卡集群。目前,包括亚马逊、OpenAI和马斯克旗下的创业公司xAI等都在建设10万卡集群,这将进一步带动Nvidia的芯片销量。然而,尽管Nvidia提出了如此雄心勃勃的计划,但一位芯片技术人士指出,单位芯片的推理算力取得百倍增长,并不意味着芯片销量总额也会百倍增长。Nvidia的芯片出货量将受制于代工生产和市场需求等因素,只会线性增长。

因此,在未来1年至2年内,Nvidia预计将回归温和增长。Nvidia首席财务官科莱特·克雷斯透露,公司可能会在2025年看到约35%的增长速度,这比2024年略低,但增长仍然相当强劲。然而,随着大型科技公司高强度资本支出的逐步回落,Nvidia的营收增速也将随之回落。

尽管如此,黄仁勋仍然对Nvidia的未来充满信心。他认为,通过提升推理效率和扩大数据中心规模,Nvidia将继续在AI领域保持领先地位。同时,他也表示愿意让利下游厂商,平衡产业链上下游的利益,以实现更加健康和可持续的发展。