近期,开源社区遭遇了一场前所未有的挑战,多家知名开源项目纷纷发声,指责AI公司大规模抓取公共资源,导致服务器压力激增,频繁出现宕机或性能大幅下降的情况。SourceHut、GNOME、KDE、Inkscape、Fedora等多个社区均表达了对这一问题的深切关注。

SourceHut的创始人兼CEO Drew DeVault在其博客中愤怒地披露了与AI模型爬虫的“拉锯战”。他透露,平台每周都会遭遇数十次短暂宕机,为应对这一危机,他不得不频繁审查并调整防护措施。DeVault坦言,他近期有20%至100%的工作时间都耗费在与这些爬虫的斗争中,多个高优先级任务因此被延误数周甚至数月。更令他无奈的是,这些防护措施往往无法有效区分真实用户与爬虫,导致真实用户也受到影响。

DeVault还提到,他的系统管理员朋友们也面临着同样的困扰。LLM爬虫的出现让所有开源项目措手不及,大家聚会时常常互相打听解决方案。KDE、GNOME等开源社区同样未能幸免。KDE遭遇了伪装成Microsoft Edge浏览器的恶意流量或爬虫,而GNOME则自去年11月以来一直受到爬虫困扰,不得不实施临时流量限制,严重影响了匿名访客的访问体验。

GNOME部署了一种名为Anubis的防御工具,要求访问者完成Proof-of-Work挑战才能访问网站。然而,这一措施也波及了普通用户,导致在某些情况下等待时间长达数十秒乃至数分钟。在Mastodon上,GNOME管理员分享的数据显示,在2.5小时内收到了约8.1万次请求,其中仅有3%成功通过验证,其余97%被判定为爬虫。

Fedora社区为保持其Pagure代码托管平台的稳定,也不得不采取极端措施,屏蔽了大量可疑IP段,甚至一度封禁了整个国家的访问请求。这种“一刀切”的做法引发了社区用户对误伤的担忧。Inkscape项目也表示,大量AI爬虫使用假冒浏览器UA或无视防爬协议,迫使维护者持续扩充黑名单。Frama软件公司的BigGrizzly也曾被恶意LLM爬虫淹没,建立了包含46万个可疑IP的列表。

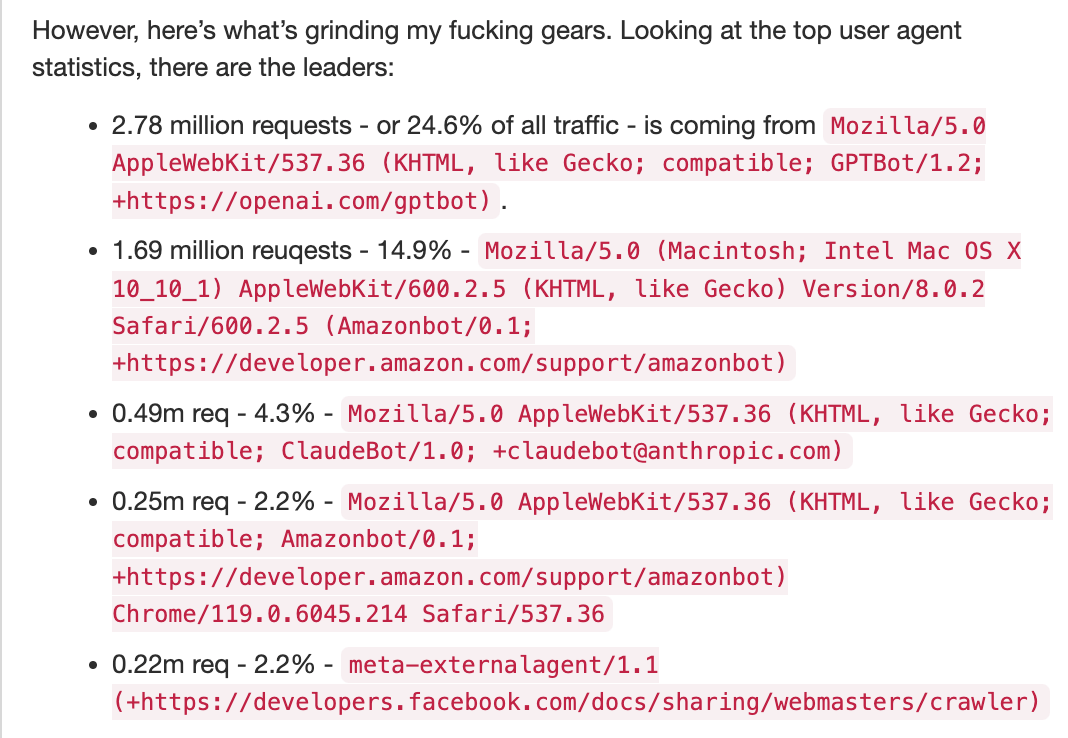

为了应对这一问题,一些开源社区开始尝试更全面的解决方案。例如,“ai.robots.txt”项目提供了一个实施Robots Exclusion Protocol的robots.txt和.htaccess文件,用于阻止列表中AI爬虫的访问。Diaspora的维护者Dennis Schubert也吐槽了类似经历,他指出,过去60天内Diaspora的网站与文档服务收到了1130万次请求,其中近70%来自AI爬虫。相比之下,传统搜索引擎如Googlebot、Bingbot等抓取行为更为克制。

Read the Docs平台曾公开数据显示,屏蔽所有AI爬虫后,其网站流量从每天800GB降至200GB,节省了约1500美元/月的运营成本。这一数据凸显了AI爬虫对开源社区造成的巨大流量压力。

面对这一挑战,开源社区呼吁更多关注与自律。DeVault在博文中抨击了加密货币、谷歌团队、硅谷AI公司等多方,认为他们将自己的成本转嫁给社会公共资源,尤其是像SourceHut这样的中小型平台。他呼吁这些机构要么承担社会责任,要么远离开源社区。目前,各大开源项目正在积极探索更高效、对普通用户更友好的解决方案,但这一过程将是一个长期博弈的过程,需要行业规范、AI爬虫自律以及社区共同行动。