近日,字节跳动旗下的豆包大模型团队宣布了一项针对混合专家(MoE)架构的关键技术优化,该优化技术能够显著提升大模型的训练效率达1.7倍,同时降低成本40%。

据内部消息透露,这项技术已在字节跳动的万卡集群训练中得到了实际应用,成功节省了数百万GPU小时的训练算力资源。这一成就不仅彰显了技术的先进性,也体现了字节跳动在大模型研发领域的深厚积累。

值得注意的是,该技术优化方案——COMET,凭借其出色的表现,成功入选了全球机器学习系统领域的顶级会议MLSys 2025。COMET以5/5/5/4的高分获得认可,被评价为“在大规模生产环境中极具应用潜力”。这一荣誉不仅是对技术本身的肯定,也是字节跳动在AI领域影响力的一次重要提升。

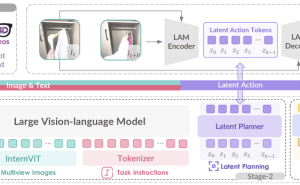

MoE架构作为当前大模型的主流选择,其分布式训练过程中存在的跨设备通信开销问题一直困扰着业界。以海外知名模型Mixtral-8x7B为例,其训练过程中通信时间占比可高达40%,严重影响了训练效率和成本。针对这一难题,字节跳动内部研发了COMET计算-通信重叠技术,通过一系列创新手段,显著减少了MoE专家通信的空转时间。

与DeepSeek近期开源的DualPipe等MoE优化方案相比,COMET具有更高的灵活性和易用性。它可以像插件一样直接接入现有的MoE训练框架,支持业界绝大部分主流大模型,无需对训练框架进行大规模的改动。这一特性使得COMET在推广和应用上具有显著优势。

COMET还支持多种MoE并行模式,部署灵活方便。其核心代码已经开源,并向开发者提供了一套友好的Python API,计划兼容Triton等编译生态。这一举措将进一步推动COMET在业界的应用和普及。

在国内大模型研发技术快速发展的背景下,相关APP的下载量也成为了观察各家大模型实用能力的一个重要指标。据最新数据显示,DeepSeek在中国区苹果应用商店免费APP下载排行榜上位居榜首,豆包紧随其后排名第二,腾讯元宝则位列第三。

然而,近期也传出了一些关于字节跳动的市场谣言。有消息称,字节跳动向寒武纪下单了4万颗580芯片,总价值高达10亿元。对此,字节跳动相关负责人迅速辟谣,称消息不实。还有传言称抖音将接入豆包大模型,为用户提供更加丰富的智能体验。这一消息虽然尚未得到官方确认,但已经引起了业界的广泛关注。

另据报道,开发出热门产品Manus的中国创业公司Monica,在2024年年初曾与字节跳动进行过一轮收购谈判。当时字节跳动出价3000万美元,但因远未达到Monica创始人肖弘的心理价位,谈判最终未能达成。接近Monica内部的从业者表示,肖弘及其团队担心被收购后会丧失产品的独特优势,因此不看好这场收购。目前Monica的估值已接近1亿美元。

尽管面临诸多市场传言和竞争压力,字节跳动在大模型研发领域的步伐并未放缓。随着COMET技术的开源和广泛应用,以及抖音等产品的持续创新,字节跳动有望在AI领域取得更加辉煌的成就。