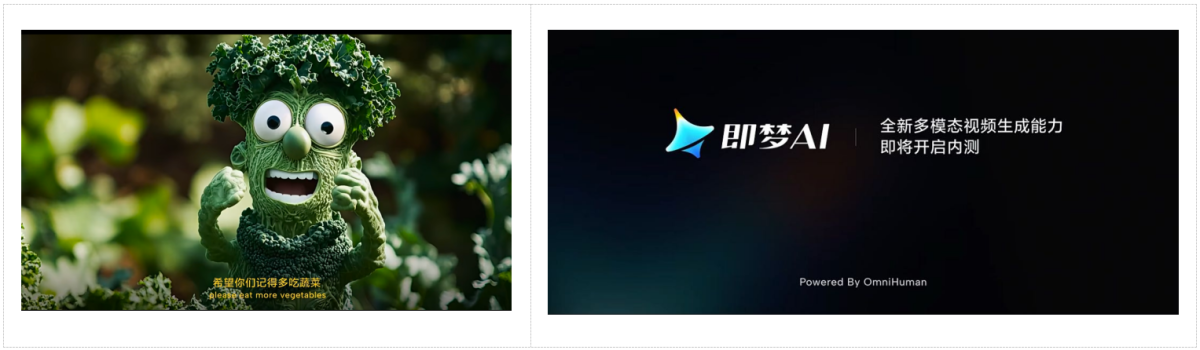

近期,即梦AI在官方社交媒体上发布了一条新功能上线预告片。视频显示,采用了全新的多模态视频生成模型OmniHuman,用户仅需输入一张图片和一段音频,就可以生成一条生动的AI视频,有望大幅提升AI短片的制作效率和质量。

图片来自即梦AI视频号内容截图

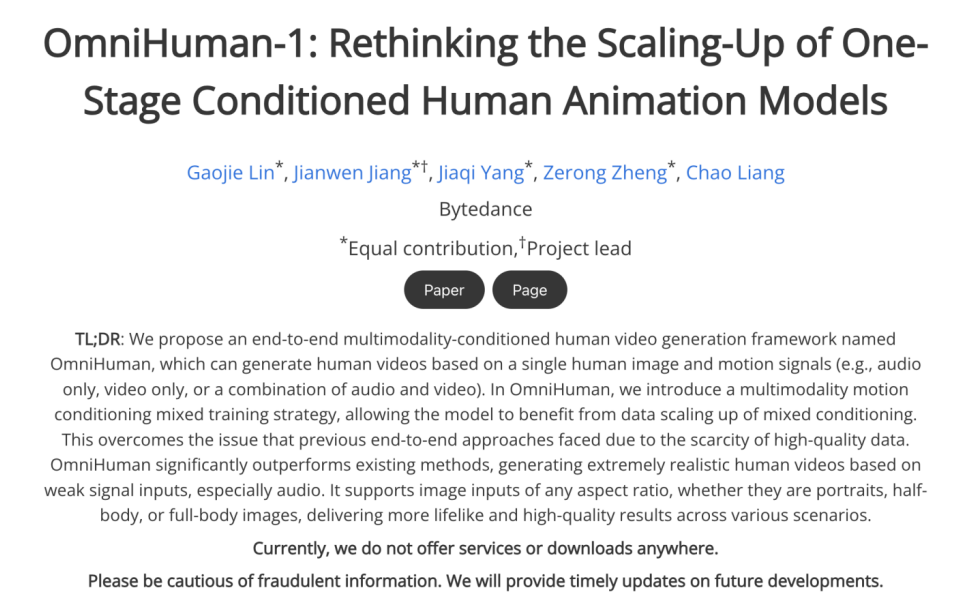

OmniHuman技术主页信息显示,该模型为字节跳动自研的闭源模型,可支持肖像、半身以及全身等不同尺寸的图片输入,并根据输入的音频,在视频中让人物生成与之匹配的动作,包括演讲、唱歌、乐器演奏以及移动。对于人物视频生成中常见的手势崩坏,也相比现有方法取得了显著的改善。对动漫、3D卡通等非真人图片输入的支持效果也较为出色,生成的视频能保持特定风格和原有的运动模式。

根据技术主页展示的演示效果来看,OmniHuman的生成效果已经具有较高的自然度。为防止该项技术被不当利用,字节跳动技术团队在主页中特别标注称,OmniHuman将不会对外提供下载。

即梦AI相关负责人透露,该模型目前已具备较好的表现,但在生成影视真实级别的视频上仍存在一定的提升空间。由其支持的多模态视频生成功能会在即梦上以小范围内测的形式进行调优调整,并逐步开放。该负责人同时表示,即梦还会对这一功能设置严格的安全审核机制,并且对输出的视频标注水印以作提醒,从而确保AI发挥正面、积极的作用,助力视频创作者更好地实现想象力的表达。