近期,AI领域的热潮再度被点燃,DeepSeek的崛起如同一枚石子投入平静的湖面,激起了资本市场对AI+产业链的广泛关注和投资热情。2月5日,开工首日,DeepSeek概念指数飙升14.73%,AI应用端和科技板块全线飘红,而2月6日早盘,A股TMT科技板块依然保持强劲势头,DeepSeek与AI算力概念持续活跃。

就在同一天,中国大模型市场也传来了一则重大消息:百度智能云成功点亮了昆仑芯三代万卡集群,标志着中国首个自研万卡集群的正式启用。上线首日,已有超过1.5万家客户通过千帆平台调用该模型。这一成就不仅彰显了百度在自研芯片与大规模AI算力布局上的重大突破,也预示着AI模型训练成本的进一步降低,为整个行业的发展注入了新的活力。

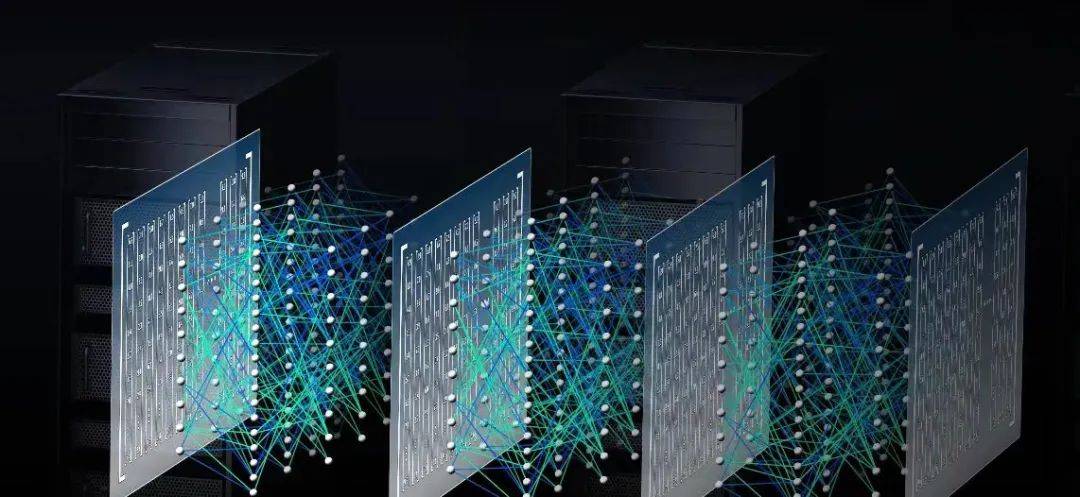

在科技巨头们纷纷加速推进AI算力基础设施建设的背景下,万卡集群成为了备受关注的焦点。那么,万卡集群究竟是什么?为何各大企业都在积极推进自研、自建万卡集群?国产万卡集群的不断演进又将如何改变智算产业?

近年来,AI大模型的涌现推动了模型规模和数据参数的指数级增长。例如,从GPT-1的1.17亿参数量到GPT-3的1750亿参数量,再到GPT-4的约1.8万亿参数量,参数的快速增长极大提升了AI模型的性能。然而,这也带来了算力需求的急剧增加,每3.5个月翻一番,每年所需算力增幅高达10倍,远远超出了摩尔定律的速度。

以GPT-4为例,其训练过程使用了约25000个英伟达的A100 GPU,持续时间长达90至100天,算力消耗巨大。随着AI大模型越来越多地应用于企业实际业务场景中,后期推理的算力需求也在不断增长。因此,大规模GPU算力集群成为了必然选择。万卡集群,即由超过一万张加速卡(如GPU、TPU等)组成的高性能计算系统,应运而生。

相比于传统的千亿参数模型,万卡集群在计算能力、数据处理速度和存储容量等方面都有质的飞跃。它能够通过并行计算和分布式处理,显著缩短模型训练周期,提高研发效率。同时,作为一种灵活的计算基础设施,万卡集群能够支持更大规模模型和更复杂的多模态任务,为AI技术的创新和发展提供了更广阔的空间。

然而,万卡集群的搭建并非易事。要想建设万卡集群规模的算力中心,通常需要面对算力使用效率、海量数据处理、多芯混训难题、智算中心设计以及稳定性与运维等多方面的挑战。这些挑战需要运用系统工程方法、精细化设计网络和软硬件整合优化等技术手段来解决。

百度智能云此次成功点亮万卡集群,得益于其在硬件和软件方面的技术创新。硬件层面,自研的昆仑芯三代在算力、能效、稳定性等方面全面升级,保障了生成式AI时代的技术主权。软件层面,百舸AI异构计算平台4.0在构建高性能网络、优化分布式训练、多芯混训、故障诊断等方面发挥了关键作用。这些技术创新共同推动了百度智能云万卡集群的高效运行。

百度智能云依托百舸AI异构计算平台4.0,实现了从集群创建到开发实验,再到模型训练、推理的全链路优化。这不仅提升了自身的智算实力,也为智算行业提供了新的发展思路。众多企业已经受益于百度智能云的AI基础设施,如生数科技、长安汽车和好未来教育集团等,它们在短时间内实现了AI应用的快速上线和性能提升。

百度智能云自研万卡集群的成功点亮,不仅在国内引发了广泛关注,也在国际市场上掀起了热议。花旗银行在研报中指出,中国模型如百度、DeepSeek等展现出高效和低成本优势,将有助于加速全球AI应用开发,推动2025年人工智能应用的拐点。资本市场上,百度在港股和美股的双双上涨也印证了这一点。

对于科技公司来说,拥有强大的万卡集群意味着在AI时代奠定了坚实的基础和竞争力。万卡集群不仅能够为公司内部的AI项目和业务提供稳定且高效的计算支持,还能提升公司在行业中的声誉和影响力,吸引更多的人才、合作伙伴和资金,形成良好的产业生态。